导读:两天前的 CCF-GAIR 大会,香港大学席宁教授讲道:“随着技术的发展,智能机器人已经从简单地替代人的能力,到扩展人的能力”。MIT 斯隆商学院的两位著名教授 Andrew McAfee 和 Erik Brynjolfsson,也说过人工智能时代的主题不应该是 “Race against the Machine”(与机器赛跑),而是 “Race with the Machine”(和机器一起跑)。

但我们如何才能并最小化 AI 给社会带来的风险与阵痛?对此,谷歌成立了一个新项目 “PAIR”,入驻了一批谷歌大脑的顶尖科学家,试图解决 AI 技术革命 “造福于人” 的终极挑战。

前言

对于 AI 将会给人类社会带来的变革,未来学家们画下了许多大饼。但这些诱人的愿景充满了不确定性,以及潜在的陷阱。

比如,我们希望 AI 技术帮助人们合理、科学地做决策,但它有没有可能反而加深社会的成见?我们梦想着 AI 把大家从九九六工作制里解脱出来,给上班族带来工作与家庭生活的平衡,但会不会大多数好处都让企业家、玩资本的得去,普通人的饭碗更加朝不保夕?

“奇点教父”Ray Kurzweil 把 AI 看做是未来三大 “paradigm shift”* 技术里(AI、基因技术、纳米技术),影响最重大、深远的一个,也是直接引爆 “奇点” 的那一个。

Ray Kurzweil

因此,不难理解为什么欧美公众与社会学家,会对 AI 的社会、伦理影响如此在意。这给谷歌等 AI 技术先驱们带来强大舆论压力,迫使他们谨慎再谨慎,并考虑每一项重大 AI 突破将给社会带来的后果以及副产品。

* 雷锋网注:“paradigm shift” 意味着科技的一轮更新换代,农业、蒸汽机、内燃机、电力以及互联网,均属于带来 paradigm shift” 的技术。

“PAIR”:沟通人与 AI

为应对上文提到的种种挑战,今日谷歌宣布了一个全新项目的开启——“PAIR”。它是 “People + AI Research” 的缩写,即 “人与 AI 研究”,目标是 “研究并重新设计 AI 系统与人交互的方式”,并 “试图让 AI 技术为每个人服务、给每个人都带来利益”。

PAIR 团队由谷歌大脑研究员 Fernanda Viégas 与 Martin Wattenberg 带领,两位均是数据可视化专家。12 名全职谷歌大脑员工将加入。除此之外,PAIR 还将与谷歌之外的研究人员合作,譬如哈佛大学教授 Brendan Meade 以及 MIT 教授 Hal Abelson。和愿景相比,PAIR 的核心团队一点也不算大。不过雷锋网获得的消息称,PAIR 是一个 “全公司尺度” 的项目,谷歌的各个研究部门会与之密切合作。

Martin Wattenberg 与 Fernanda Viégas

它的使命,听起来与谷歌参与发起的 The Partnership on Artificial Intelligence to Benefit People and Society (“造福于人和社会的 AI 合作组织”。没错,就是名字长到塞不进标题、让媒体圈一致吐槽的那个组织)很是相像。该组织的参与者还包括 Facebook、微软、IBM、亚马逊。谷歌表示,PAIR 将会作为这个名字特别长的组织的补充。两者的工作内容都包括开源新的技术研究平台、促进 AI 研究透明度的提升。这两个组织的目标,听起来与 OpenAI 也有些相似。

谷歌在博客宣布,PAIR 的研究工作会分为以下三个领域:

工程师和研究人员:AI 由人来创造。怎么让工程师们更方便地开发、理解机器学习系统?他们需要什么样的教育资源和实践工具?

行业专家:AI 如何协助各个领域专家的工作?怎样更好地为医生、技师、设计师、农民、作曲家等职业服务?

普通用户:怎样才能保证机器学习的普适性,为每个人服务,让每个人都从 AI 的发展中受益?设计思维是否能打开一扇全新的大门,诞生一批前所未有的 AI 应用?我们是否能让 AI 背后的技术民主化?

面对 AI 的 “不平等” 挑战

它们所服务的,是一个相当宽泛、也相当宏大的愿景。谷歌表示,PAIR 会审视 AI 供应链中影响每个人的一系列问题——从写代码的研究人员,到使用(或即将使用) AI 专业工具的医生、农民等职业。另外,让 AI 对用户友好也是一大工作方向,让 AI 技术便于理解(比如说,AI 算法的可解释性就是一个极有挑战性的问题),同时,保证 AI 技术平等地对待用户。

什么是让 AI“平等对待用户”?

现实证明,社会中的偏见、成见、不平等,会被有意无意写入 AI 的代码里。比如说,无法识别黑人的面部识别软件;设计为男医生、女护士服务,而不为女医生、男护士考虑的语言处理程序。

那么,造成上述情况的原因是什么呢?

最常见的原因是用于训练的数据集。要么,它包含的信息不完整(例如缺乏男护士的数据),要么存在某种形式的偏见。

发布 Facets 开源工具

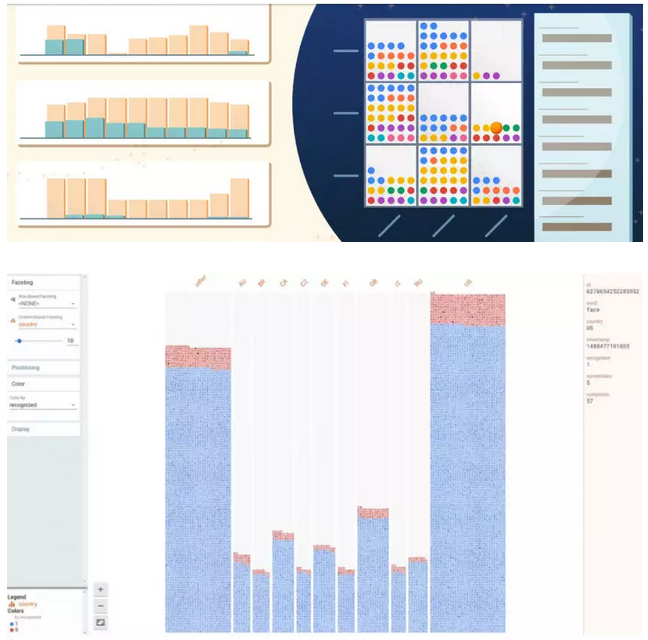

针对上面的问题,PAIR 在诞生的同时,公布了它的第一份工作:Facets Overview 和 Facets Dive。这两个开源工具让程序员检查数据集的工作变得更方便——提升数据可视化体验。

上图(第二张)是 Facets Dive 里的截图,它在检查一个面部识别系统。它通过每个人的国籍筛选检验器,把每个国家人口的错误与成功识别率进行对比。这很方便得让研究人员看出哪个国籍的错误率较高,因而需要更多数据集、更多样本,并进行相应调整。

想试一下这两个开源工具?请访问这里。

PAIR 会陆续发布更多的开源工具,让 AI 技术更透明公开的努力也已经提上日程。就雷锋网所知,谷歌还将设立奖金和实习机会来支持相关研究。

后话

笔者认为,越来越多 AI 公益组织的建立,以及谷歌等 AI 企业的投入,在一定程度上是对社会公众的回应:回应大众对 AI 技术的疑虑或者说担忧。

作为号称是足以媲美互联网的 “paradigm shift” 技术革命,AI 有着迅速颠覆传统生活沟通方式的能力,这引发的伦理讨论不绝于耳。这又在很大程度上对 AI 领头羊企业造成了相当大的舆论压力——譬如说,开发自动驾驶,就不得不顾虑到全球千万职业司机的生计。小型初创公司可以一往无前,但谷歌这个体量的企业,势必需要拿出一个足以在一定程度上打消公众疑虑的方案:怎样避免负面效用,怎样让工作受威胁的职业有个过渡,诸如此类。

PAIR,这个名字很好记,并且意有所指(“pair” 意为 “匹配”,一家试图更好地沟通人与 AI 的组织以此来命名,可谓十分应景)。但在谷歌高层的构想里,PAIR 成立的目的有几分公关、有几分是要实打实的研究,外人不得而知。虽然负责人 Fernanda Viégas 与 Martin Wattenberg,这两位一流数据可视化专家足够重量级,但毕竟 PAIR 要解决的问题太大、太宽泛,无法排除 “一拳头打到空处” 的可能性。当然,这些都需要我们耐心等待。(来源:雷锋网)